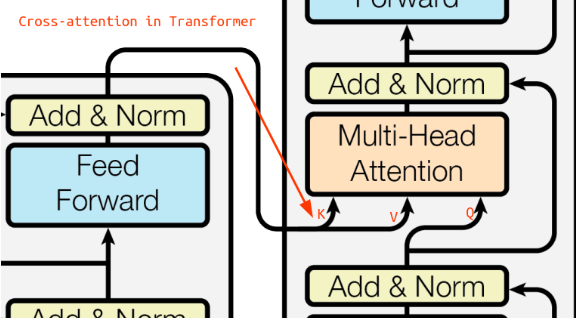

Analogia do self-attention, jednak tutaj mamy dwie sekwencje i . W Scaled Dot-Product Attention key (K) i value (V) liczymy z sekwencji , a query (Q) z sekwencji .

Użyte w Attention Is All You Need (ale wtedy jeszcze nie nazywane cross-attention) w dekoderze transformera gdy odtwarzany jest przetłumaczony tekst: