Problem

Nasz bidder w zbiorze danych do uczenia ma tylko te aukcje, które wygraliśmy. Jeśli wcześniej biddowaliśmy nisko, tzn. zawsze przegrywaliśmy aukcje, które są dużo warte (inne biddery biddowały wysoko), to nigdy nie nauczymy się biddować wyżej. W dodatku jeśli zależy nam na wzięciu jakiegoś bid requestu do uczenia to musimy zawyżyć odpowiednio cenę (źródło: Exploration with Model Uncertainty at Extreme Scale in Real-Time Bidding).

Problem ten można wyrazić jako selection bias

Pomysły

Entropia jako utility

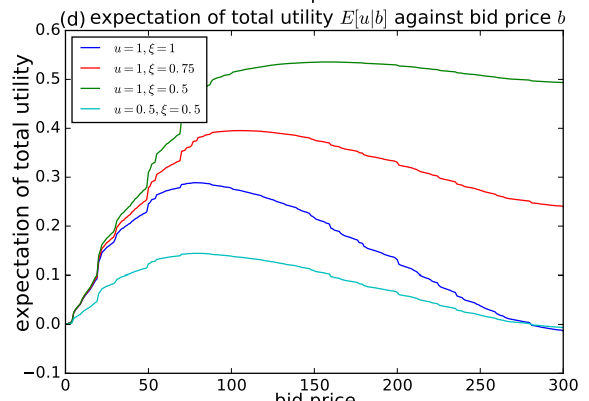

Musimy oceniać czy dana aukcja (dany bid request) jest dla nas wartościowa pod kątem trenowania czy nie. Do oceny używamy utility function, która dosłownie mierzy użyteczność bid requestu dla naszego modelu. Czyli chcemy wybrać takie aukcje, które będą maksymalizować sumę utility (źródło: Bid-Aware Active Learning in Real-Time Bidding for Display Advertising). Trzeba tylko uważać na koszty (tzn. budżet) - skoro maksymalizujemy sumę, to być może będzie się opłacało zebrać więcej bid requestów o mniejszej utility niż mnie bid requestów o większej utility. Zależność będzie taka, że suma utility w zależności od ceny bidu będzie najpierw rosnąć a potem spadać:

W publikacji Bid-Aware Active Learning in Real-Time Bidding for Display Advertising jako utility jest przyjęta Entropia, czyli niepewność (a konkretnie Entropia binarna). Uwaga: niepewność tutaj to nie jest niepewność modelu dotycząca konkretnej odpowiedzi (model bayesowski mógłby zwracać rozkład, i można by policzyć entropię tego rozkładu), ale Entropia binarna p-stwa zwróconego przez model, więc efektywnie utility będzie tym wyższe im większe p-stwo zwróci model.